[ad#ad-tubiello]

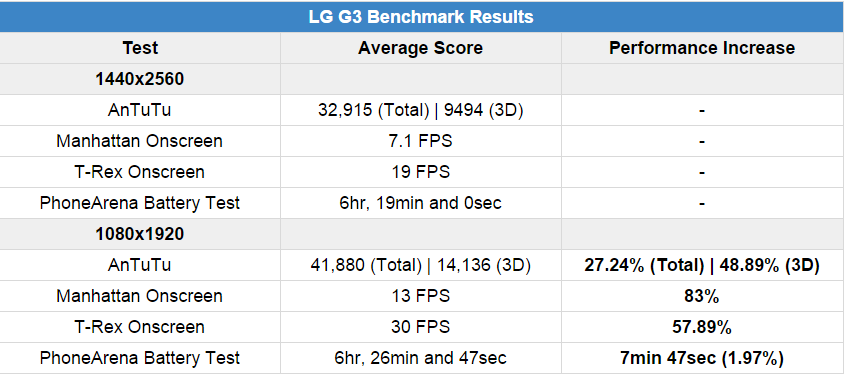

Phonearena ha infatti messo a confronto prestazioni e autonomia di LG G3 dapprima in condizioni standard, e successivamente con la risoluzione del display abbassata a 1920×1080.

Secondo quanto riportato, il test è stato condotto su un modello coreano F400S, con 3 GB di RAM. Sul device è stato installato il firmware ufficiale LG di Giugno 2014 e successivamente effettuati tutti gli update OTA a disposizione (senza arrivare a Lollipop).

Dopo aver effettuato i test con AnTuTu e GFXBench e messo alla prova l’autonomia del device con un test proprietario, sul device è stato effettuato il root e installato Nomone Resolution Changer, portando la risoluzione a 1920×1080. I test sono stato quindi rieseguiti, ed ecco i risultati.

Come lecito aspettarsi, l’abbassamento della risoluzione video giova notevolmente alle prestazioni del device, specialmente nel test 3D. L’autonomia non sembra invece trarre particolari benefici dall’operazione: la differenza tra Quad HD e Full HD è di poco meno di 8 minuti.

E che vi avevo detto?

Ti stavi fregando le mani da mesi, aspettando il momento di scriverlo… ammettilo!

;-)

Era già venuto fuori tempo fa, vedi http://www.androidauthority.com/galaxy-s5-lte-a-battery-benchmark-414550/

Bah, se non ricordo male lui rimarcava una riduzione sostanziale della durata della batteria, non delle prestazioni. E la durata della batteria tra FHD e QHD si riduce sì ma in modo praticamente trascurabile, cioè dell’1.97%

Però il decremento prestazionale ce. Il soc e talmente potente da non risentirne in condizioni di uso normale ma secondo me con la gpu perennemente sotto stress diminuisce anche l autonomia. Diciamo che ad esempio asphalt 7 utilizzi la gpu al 80% per girare al massimo delle prestazioni. Con qHD invece la usa al 100%. Mi sembra possibile che quindi consumi di più ma sono casi estremi.

Consuma di più nel 3D, e SOLO in quello! I risultati (Total) di Antutu riportati nella tabella COMPRENDONO anche il 3D!

Ma non eri quello che diceva che il qhd causava un decadimento dell’autonomia della batteria? Perché mi sembra che sia stato dimostrato il contrario, per quanto riguarda i frame ben vengano qualche frame in meno per avere in cambio una qualità video impagabile

il G3 ha uno schermo orribile rovinato dall’oversharpening inoltre

chiara uscita di chi non l’ha mai avuto, non per difendere il g3 ma l’oversharpening non “sta di casa” mi spiace deluderti.

Magari fossero tutti così “orribili”…..

Il tuo S5 ha uno schermo orribile

il G3 uno schermo orribile??? Ahahahahahhahahahahahahahahahahahahhahahahahahahahahahhahahahahahahahahahahhahahahahahahahahahahahahhahahaha (fatemi prender fiato…) Ahahahahahhahahahahahahahahahahahahhahahahahahahahahahhahahahahahahahahahahhahahahahahahahahahahahahhahahaha!!!!

Attualmente è il device con lo schermo dalla risoluzione più elevata e dalla resa cromatica più vicina ai valori ideale. Se proprio vogliamo trovargli un difetto, è leggermente meno luminoso rispoetto alle soluzioni fullhd, e questo è dovuto alla densità di pixel maggiore. Tuttavia, la visibilità anche sotto il sole è ottima, quindi la minor luminosità non è un problema. Per classificarlo come “orribile” significa che non sai di cosa stai parlando.

Ti correggo solo sulla storia dello schermo dalla risoluzione più elevata :P

Per il resto, quoto :D

Ottimo display ma il SuperAmoled FHD del Note 4 è ancora superiore… come si evince dai test di diversi siti specializzati, a partire da DisplayMate

Assolutamente NO! Io ho sempre detto che l’aumento della risoluzione, ai fini del consumo di corrente, conta poco e niente.

Infatti, dato che fisicamente i pixel da alimentare non cambiano, modificando la risoluzione di uno schermo :P

I pixel non vengono nemmeno “alimentati”, su un display di questo tipo. Funzionano come dei rubinetti per la luce, quella che viene dal pannello led sottostante.

Beh oddio, retroilluminazione o meno (sappiamo tutti che nn é un amoled), parliamo sempre di piccole lampadine che si accendono e spengono xD

NO! I pixel NON EMETTONO LUCE, cambiano solo il piano di polarizzazione. Che siano accesi o spenti consumano uguale!

E come cambiano polarizzazione? Da soli senza alcuna richiesta di energia? LoL

San tutti che non emettono luce, ma ogni singolo pixel ha bisogno di una sua alimentazione. Tra FHD e QHD ci sono piú di 1milione di pixel di differenza

Cambiano polarizzazione COMUNQUE, 50 volte al secondo o giù di lì, qualunque cosa appaia sullo schermo. INFORMATI! ed, in ogni caso, rispetto ai LED retrostanti che emettono la luce consumano poco e niente!

Evidentemente non hai capito cosa intendo.

Te lo semplifico: avere 1milione e passa di Pixel in più, consuma maggiore batteria del non averli. Punto.

Evidentemente non hai letto l’articolo, o non sei in grado di capirlo. NON È VERO! Se non in piccolissima percentuale! Il consumo maggiore è dato dalla GPU che, SOLO PER IL 3D, deve calcolare molti più dettagli.

E allora spiegami come mai un G2 (che differenzia (in HW) da G3 solo per una CPU praticamente uguale ma leggermente più lenta e lo schermo in FHD) a consumare mooolto meno di G3? E parlo di uso normale/quotidiano, non di giochi pesanti

EVIDENTEMENTE il G3 non è proprio uguale al G2, non pensi? Anche perché è uscito quasi un anno dopo!

Stessa batteria, stesso sistema (con qualche differenza e UI diversa) portabile su G2 (senza cambi di durata), SoC molto simile (tra Snap 800 2.3Ghz e Snap 801 2.5Ghz non credo ci siano tutte ste differenze), stessa GPU (che su G3 lavora di più ed è sotto maggior sforzo nel 3D). Le altre differenze derivano di più da un’antenna leggermente migliore su G3 (in quanto ricezione), stabilizzatore migliorato, laser (attivo solo in fotocamera) e poco altro. Effettivamente è da considerare un G2.5, dato che le uniche differenze sostanziali stanno appunto nel laser (che, tra l’altro, consuma na cippa), CPU un pochetto più potente e uno schermo molto più definito e grande. Sono dell’idea che almeno il 50% dei consumi maggiori che ha rispetto al G2 siano appunto dati dallo schermo, sia per il bisogno di illuminazione maggiore, sia per l’alto numero di Pixel in più. Parliamo di un buon 33%.

P.S.: non sto denigrando G3 xD anzi, ce l’ho e mi ci ritrovo moooolto bene

Non è che se tra 800 ed 801 c’è solo 1 di differenza vuol dire che siano molto simili, eh… Inoltre potrebbe esserci una diversa ottimizzazione del software tra i due telefoni, e NON mi sto riferendo alla versione di Android, una diversa luminosità, sezione radio, ci sono moltissime cose che potrebbero essere cambiate “sotto il cofano” e potrebbero avere la loro influenza sui consumi. Imputare allo schermo il 50% o il 33% del maggior consumo, scusa, ma vuol dire proprio dare i numeri.

Tra telefoni diversi ti do ragione, ma tra G2 e G3 non cambia molto. Lo dimostra anche il fatto che su G2 puoi installare la rom G3 senza risentire in nulla :P

E ho solo detto che il 50% (ipotesi mia, ovcio che nn siano dati scientifici) dei consumi in piú rispetto al G2 é dettato dalla risoluzione maggiore O: mi stai dicendo che due telefoni quasi identici hanno tante differenze in batteria solo per la radio e poco altro? Pleaze :P

Hai mai installato un sistema operativo su un PC? Per caso c’è la versione per Intel Celeron ed un’altra per Intel I7? OVVIO che LG abbia fatto la nuova ROM compatibile sia per il G3 che per il G2, ma non vuol dire che sono uguali!

Wat lol

Chi ha mai detto questo? Evidentemente scindi le parti senza comprendere ol discorso :P inoltre non mi va di continuare un discorso OT che cerchi inutilmente di “vincere”

Vabbè, vai a dormire che è meglio.

p.s. Si scrive “what”

P.P.S.: Scrivere what senza H é un modo di fare ma, va beh lol

p.p.p.s Un modo di dire, semmai.

1) Qual’é il tuo problema con il mondo?

2) É anche un modo di fare, un atteggiamento, come lol, asd e via discorrendo

3) Ripeto: qual’é il tuo problema con il mondo?

1) Un modo di fare è quando fai qualcosa, un modo di dire è quando dici qualcosa, se proprio ci tieni scrivere “wat” anziché “what” potrebbe essere un modo di esprimersi.

2) Io non ho nessun problema col mondo in generale, il mio unico problema è che mi ostino a rispondere a dei co##ioni come te.

3) Ripeto: CO##IONI.

Un modo di dire é, appunto, dire o scrivere un detto. Wat é sia un modo di dire che un modo di fare, dato che imito un atteggiamento.

La cosa piú buffa é che fai il pignolo su un argomento di cui non frega nulla a nessuno e che non c’entra niente con il resto e sei anche capace di insultare gratuitamente lol

Gg amico :P

Giusto, è un modo di fare a parole. Geniale!

secondo me invece,la maggiore durata della batteria è plausibile,

non tanto per il discorso pixel accesi pixel spenti,che è una cazzata,ma per il minore carico della gpu,poiché lavora con meno pixel,quindi frequenze e tensioni piu basse,che alla lunga possono giovare sulla batteria.

Ma se ti ho appena detto che la GPU si passa tutti i pixel 50 volte al secondo! Per la GPU le operazioni 2D sono ACQUA FRESCA, LEGGI LA TABELLA nell’articolo qui sopra! Quello che pesa, perché i pixel se li deve calcolare, è SOLO IL 3D! Ma quante volte lo devo ripetere!

il mio 38334…

A parte che i Benchmark differiscono tanto tra più telefoni “uguali” perché sono le condizioni che variano, l’autonomia del G3 non migliora in FHD perché, risoluzione più bassa o no, i pixel sono sempre quelli. Fisicamente il G3 deve alimentare quel numero di Pixel. La differenza è che la GPU deve gestire “meno dati” per quanto riguarda texture e quant’altro.

Se un PC portatile, ad esempio, cambiare la risoluzione dello schermo può influire sull’autonomia se quest’azione influisce tanto sulla GPU. Questo perché lo schermo è alimentato dal PC stesso; per lo smartphone vale la medesima cosa :P

non capisco perchè vieni a raccontare a me questa storia, è italba che devi convincere. In questo forum sono stato aggredito svariate volte perchè sostenevo che il qhd non influiva sulla durata della batteria ma piuttosto è la dimensione del display che lo fa. Per quanto riguarda il consumo della gpu derivante dalla risoluzione piu elevata direi che il consumo maggiore è irrilevante se non nel momento che si vada ad utilizzare un videogioco che sfrutta una notevole capacità di calcolo (come se fossimo tutti li, tutto il giorno a giocare….ma dai..), tornando al consumo della cpu in una risoluzione piu elevata il fatto che l’autonomia sia calata di una manciata di minuti in un contesto di svariate ore dimostra che rimane ampiamente in una tolleranza molto probabilmente non imputabile nemmeno alla risoluzione ma alle condizioni che variano. Conclusione: risoluzione+elevata NON EQUIVALE maggior consumo.

Tra, credevo, nel tuo commento precedente, che intendessi dire la cosa del consumo in un ambito più generale e non legato all’effettivo schermo xP

O tu non hai proprio letto i miei post o mi confondi con qualcun altro. Io ho sempre detto quello che sostieni tu riguardo al consumo, in più ti dirò anche che la risoluzione più elevata NON RALLENTA un bel niente. Nel caso della grafica 3D, e SOLO in quello, la GPU deve lavorare di più per calcolare più dettagli, ma un telefono non lo si usa solo per giocare!

Era risaputo!!! Ma tanto il qhd lo hanno messo perchè fa figo agli occhi delle persone che non ne sanno una mazza (90% della popolazione mondiale) e le spinge a comprare tutto quà!!! Invece a persone che come noi una briciola ne sanno fa inca***re!!!

Spiacente, io ho sempre detto che il Qhd, sugli schermi superiori a 5″, può migliorare la qualità dell’immagine percepita, anche se non si riescono a distinguere i singoli pixel. Ad ogni modo, visto che male non fa (neanche alla batteria) non c’è proprio motivo di demonizzarlo.

Già

Forse, è dico forse, un motivo c’è. Il prezzo, magari full HD costa meno

Probabile, ma non è la differenza reale di costo, quella sarà di poche decine di euro. È possibile, tuttavia, che i produttori se ne approfittino per alzare il prezzo più del dovuto, vista la novità, ma è una differenza destinata a ridursi nel tempo.

Però si deve dire che il G3 attualmente costa meno rispetto a tutti gli altri top di gamma FullHd,benché offra uno schermo migliore.

Beh oddio, ok che non cambia in termini di consumo il cambio di res su uno schermo QHD che riproduce l’FHD, ad esempio, ma, fisicamente, tra uno schermo reale in FHD e uno reale in QHD cambia molto. I consumi maggiori sul 2k sono dati da una maggiore richiesta di alimentazione e dallo sforzo maggiore della gpu

Bè che non faccia male non credo proprio dato che è stato appena dimostrato… fa male sopratutto alle prestazioni e alla fluidità se il processore non è abbastanza potente! E g3 ne è la conferma dato che ha micro lag per viola del processore che non suppalorta il qhd… (qualcom stessa lo dichiara) poi per la batteria non credo non cambi proprio nulla, può essere che hairagione l immagine percepita migliore ma di pochissimo se non nulla… basta guardare il full hd di s5!! Sicuramente sono più i contro che i pro ad avere un qhd poi vabbe ognuno la pensa a modo suo

Ma tu lo hai letto l’articolo? Sei ben sicuro di aver capito quello che dice? IL G3 avrà pure dei micro lag ma NON SONO CAUSATI dalla risoluzione QHD! L’unica cosa, rispetto al fullhd, che rallenta e consuma di più (forse) è la GRAFICA 3D!

Si l ho letto bene l articolo e i micro lag dipendono amche dal qhd perchè il processore non lo supporta!!! Non me lo sto inventando basta andare sul sito della qualcom e informarsi anche genericamente!! L ho letto su vari articoli che il g3 lagga per il qhd perchè il processore non lo supporta…. son per nulla samsung con s5 e htc con m8 sono restati sul full hd pur montando lo stesso processore di g3…

Se non lo supportasse non funzionerebbe…

Non necessariamente… l la qualcom afferma che la risoluzione massima che supporto l 801 per lavorare al meglio e il full hd…. il qhd lo tiene ma non nei migliori dei modi(e si vede)!! Come hai detto tu in un commento che ho letto ce lo hanno messo per avere una scusa buona per aumentare il prezzo del telefono al momento del lancio nel mercato… ma di certo non giova al telefono, tanto come ho detto io già in precedenza la stragrande maggioranza delle persone non lo nota nemmeno

I lag e microlag sono una cosa opinabile e soggettiva. I numeri, dei benchmark e del consumo, dicono tutt’altro. Inoltre, i “core” dell’801 neanche lo sanno, nella maggior parte dei casi, se lo schermo è fullhd o qhd. Si limitano ad inviare istruzioni del tipo “scrivimi questo in questa posizione dello schermo”, “disegnami un rettangolo da qui a lì”, cose del genere. Poi la GPU si preoccupa di disegnare queste cose sullo schermo ed a ridisegnarle diverse decine di volte al secondo.

Nonfunziona esattamente così la cpu ne risente eccome ed e vero che i lag nella maggior parte dei casi sono soggettivi e opinabili ma non in questo caso… che il g3 lagghi per via della risoluzione troppo alta è un dato di fatto!! Ti lascio con questo articolo dove afferma che il qhd e responsabile dei lag del g3 e il primo che ho trovato ma ce ne sono un sacco dove ti spiegano bene nel dettaglio il perchè accade…http://www.keyforweb.it/lg-g3-incrementare-le-prestazioni-abbassando-la-risoluzione/ poi ognuno la pensa a suo modo

Bravo, apri il link che hai postato, e poi leggi qui in cima. È LO STESSO ARTICOLO! Il 27% di incremento Antutu che riporta è causato in massima parte (E LEGGILA LA TABELLA!) dal 49% di incremento nel 3D, COMPRESO nel totale!

E lo stesso articolo con la differenza che li specifica che il qhd gli da problemi al telefono!!! Io la tabella l ho letta benissimo e tu ancora non capisci che vale zero!! Solo per il fatto (ed è stato spiegato e credo anche dimostrto… E INFORMATI) che il test e stato condotto da un diplay qhd!! Mi spiego meglio…. se abbassi la risoluzione in uno schermo che ha 100 pixel ad una risoluzione che ne ha 80 la cpu deve lavorare per allungare questi pixel e rinsanare lo spazio perso (dato che è uno schermo che ne tiene 100) diversissima la faccenda se lo schermo nasce full hd e quindi non ha bisogno la cpu di lavorare per allungare i pixel e quindi i numeri cambierebbero rispetto a questi riportati nella tabella!! Prova a prendere un g3 che esce di fabbrica già con un diplay full hd e uno con il qhd ripeti il test e ti assicuro che non ritroverai questi numeri!!

Ps: non è una mia teoria ma è di chi ne sa molto più di me

Ecco, IO per esempio ne so molto più di te, fidati. Vatti a leggere qualche minima nozione di computer grafica, windows e viewport, interpolazione, matrici di trasformazione e poi ti convincerai che queste operazioni grafiche di base, nelle quali tra parentesi la CPU non si sporca neanche le mani, contano ZERO o quasi. La GPU non si stanca proprio a farle, neanche 24 ore al giorno. Il confronto di due telefoni uguali con schermi di risoluzione diversa è già stato fatto con i Samsung S5, vedi http://www.androidauthority.com/galaxy-s5-lte-a-battery-benchmark-414550/ , leggitelo e guarda come è andato a finire. Con questo chiudo questo argomento, per il futuro impara ad informarti invece di sostenere delle idee preconcette per partito preso.

Ho visto la tabella e ho letto l articolo che mi hai postato la differenza tra i 2 device è pressochè nulla ma questobe dovuto dalla diversità dei 2 adreno montati su i 2 device nell articolo viene specificato che l adreno 420 offre un 40/60% di prestaxioni in più è PIÙ EFFICENZA ENERGETICA…. comunque sia detto questo magari è vero che ne sai più di me come di tutti quanti in questo blog dato che sei l unico di parte con quello che affermi o quasi… magari se come dici tu la cpu e la gpu non vengono nemmeno sfiorate dal discorso risoluzione qualcom specifica per nulla la massima risoluzione supportata per ogni processore che produce… ma va bene ognuno poi la vede modo suo e ripeto magari puoi avere anche ragione dato che ti credi esperto in materia ed io di certo non lo sono e mi baso su quello che leggo da appassionato su vari forum e recensioni…

La GPU altro che se viene sfiorata dal discorso risoluzione, fa tutto lei! E comunque per le gpu sono compiti all’acqua di rose. Se L’Adreno 420 ha il 40% di prestazioni in più e più efficienza non vuol dire che la sua efficienza sia del 40% migliore, o che possa fare il 40% in più di lavoro consumando lo stesso. La Qualcomm specifica la massima risoluzione per i suoi SOC (non processori) perché dentro i SOC ci sono i processori veri e propri (core), la sezione radio e la GPU, oltre a vari chip di contorno. Non è questione di vedere le cose ognuno a modo suo, è questione di SAPERLE.

So bene chebi processori sono i core del soc stesso ma non stiamo a puntualizzare… se qualcom lo specifica vuol dire che un perchè c è e sia la gpu che la cpu ne risentono eccome almeno quà si afferma totalmente il contrario di ciò che dici (discorso batteria a parte che magari hai anche ragione avendo fatto una ricerca oggi ma per il resto proprio no) http://lg.hdblog.it/2015/02/17/LG-G3-migliora-molto-abbassandolo-a-fullHD/

Un’altra volta? Ma che, sei andato in loop? È SEMPRE LA STESSA TABELLA! SVEGLIAAA!

Rileggi quello che ti ho risposto ieri.

Mah,io ho un g3 e non lagga per nulla… Sarà miracolato?

Sono micro lag e ci sono… quasi impercettibili ma che su un telefono top gamma almeno nel momento in viene commercializzato a parer mio non dovrebbero assolutamente esserci daato che lo paghi fior di quattrini

Effettivamente, quello che importa è riuscire a nascondere al meglio i Pixel e persino un 280DPI ci riesce, se non li vogliamo cercare :)

Mah…9000 punti di differenza su antutu solo per i test 2d/3d mi sembrano un po tanti…secondo me la reale differenza è di 3/4000 punti.

In base a quale studio scientifico affermi ciò????

In base al fatto che il mio s5 con la stessa gpu realizza 13400 punti sul 3d e 1600 sul 2d . Ora… siccome questi sono gli unici test influenzati dalla risoluzione e ci sono 15000 punti in gioco ti sembra possibile che aumentando la risoluzione a Qhd ci sia un calo di 9000 punti su 15000? Francamente a me no. Spero di avere soddisfatto la tua sete di conoscenza e anche quella di tutti i personaggi che ti hanno pure dato il like.

Comunque le tue sono supposizioni, quindi quando potrai dimostrare (non solo a me ma anche a persone ben più importanti di me in questo campo) che ciò che dici corrisponde a realtà allora ti darò ragione

E infatti se tu avessi letto il mio primo post avresti visto che c’era scritto un bel “secondo me” e non “asserisco con prove di fatto”… ma evidentemente non l’hai letto.

Comunque hai ragione, difatti il mio G3 con Antuntu fa quasi 41000… (11300-1640)

Come volevasi dimostrare ;)

Quoto Matteo,il G3 in Quad Hd fa 12000 punti,quindi lo scarto si riduce a 2-3000 punti in 3D.

Il concetto espresso da lattina è chiarissimo, secondo il suo personale parere la differenza è troppa, e ti ha pure dato la motivazione. L’unica cosa immotivata qua è la tus critica. Inoltre parlavi di dati scientifici, ma scusa, cosa c’è di scientifico nel test eseguito?? Conosciamo tutti l’affidabilità dei benchmark

S5 è un terminale diverso, con un Android diverso, gestito da un’interfaccia diversa, creata da un’azienda diversa che ha venduto, a te, un telefono che tu usi in maniera diversa da altri. Sono piuttosto sicuro che se fai il test con altri 10 S5, solo alcuni faranno un punteggio SIMILE al tuo.

Ma visto che non si parla di 100 punti ma di 9000 su 40000 la mia osservazione mi sembra più che lecita.

Il punto è solo che i benchmark sono tanto (troppo) variabili :) io con G3 faccio punteggi simili ai tuoi (11k 3D 1.6k 2D), eppure ho il loro stesso telefono :P dipende dall’uso da troppi fattori xD

Ma infatti il mio appunto era per ribadire che quei punteggi per me sono assurdi ma non quelli alti bensì quelli bassi ! Anche mio fratello ha il g3 e realizza punteggi intorno ai 40/41000 ( circa 3/4000 punti in meno del mio s5 e per me questo è un punteggio ragionevole mon i 32000 riportati dalla tabella.

Boh : ti dirò, ho visto bench di g3 anche a 27/29k xD

[…] (…)Continua a leggere LG G3, prestazioni e autonomia a confronto con display Quad HD e Full HD su Andro… […]

Ma ci sono tool, magari di xda che permettono di abbassare la risoluzione per app e giochi?

[…] (…)Continua a leggere LG G3, prestazioni e autonomia a confronto con display Quad HD e Full HD su Andro… […]

Perché sul G3 le prestazioni aumentano e sul N6 invece addirittura diminuiscono del ~20%?

Perché Nexus 6 si sta rivelando una fagghia in tutto (parlo da NON possessore di N6)

[…] (…)Continua a leggere LG G3, prestazioni e autonomia a confronto con display Quad HD e Full HD su Andro… […]

…meno di 8 min di differenza tra Quad HD e Full HD? …. alla faccia di tutti quelli che …. “lo schermo QHD è una porcata perchè prosciuga subito la batteria”

Ti copio e incollo una risposta che ho dato poco fa più sopra

“L’autonomia del G3 non migliora in FHD perché, risoluzione più bassa o

no, i pixel sono sempre quelli. Fisicamente il G3 deve alimentare quel

numero di Pixel. La differenza è che la GPU deve gestire “meno dati” per

quanto riguarda texture e quant’altro.

Su un PC portatile, ad

esempio, cambiare la risoluzione dello schermo può influire

sull’autonomia se quest’azione influisce tanto sulla GPU. Questo perché

lo schermo è alimentato dal PC stesso; per lo smartphone vale la

medesima cosa :P”

Non capisco perche’ cercare sempre una critica .di decice me ne sono passato parecchi dalle mani ora ho un g3 con prestazioni di turto rispetto nel normale utilizzo la tripla risoluzione la si nota specie nel micro(piccole lettere o immagini)il display sembra piu lucido e vivido della media .

Un difetto lo si puo trovare nella durata della batteria ma nel mio caso da quando ho aggiornato a lollipop

[…] (…)Continua a leggere LG G3, prestazioni e autonomia a confronto con display Quad HD e Full HD su Andro… […]

Io ho un g3 e devo dire che con qhd le prestaziomi mi soddisfano a pieno e provandolo con la Risoluzione abbassata non ho visto tutte queste difderenze, più un lieve miglioramento ma nnt di eccessivo, più che altro io ho uno schermo qhd (ma vale anche se compro un televisore con questa risoluzione), poi ci metto sopra un film blu ray, 1080 p che è il massimo della risoluzione e vedo che non riesco a sfruttare la potenza dello schermo. Se io ho un dispositivo qualsiasi, anche tv con una risoluzione altissima devono esserci i film/giochi con tale risoluzione, senno nn riesco a sfruttarlo.

Io su Antutu ho avuto circa 39k con qhd e 41k con 1080p. Fantastico.

Il consumo del displai del G3 non varierà mai semplicemente diminuendo la definizione in output. L’hardware non cambia quindi i consumi sono gli stessi, i pixel vengono semplicemente usati in downsampling. Quindi questa prova si può a mio avviso considerare attendibile soltanto dal punto di vista prestazionale

Esatto!! Non è che una risoluzione minore (interpolata via software) “spenga” i pixel. Il fatto che la durata sia praticamente uguale sta a dimostrarlo. Altra cosa è mettere a confronto stesso hardware e schermi di risoluzione differente nativa.. tipo Oppo Find 7/Find 7a. Li si vede quanto pesa uno schermo 2k in termini di consumi.

Esatto

Il display del G3 settato il quhd è un idrovora per la batteria, non apporta nessun tangibile miglioramento delle immagini rispetto al fullhd… Provate a settare il g3 in fulhd e confrontate immagini e consumi… Solo un falco nota la differenza abissale…e perdippiu quasi si dimezzano i consumi. Inutile e didpendioso, per il resto il G3 è un gran telefono!

Non è possibile che i consumi si dimezzino O: solo in game o app particolarmente esose di GPU i consumi potrebbero migliorare :P

Da possessore di G3 posso dirvi che installando una Custom ROM basata

sulla Stock (io uso ChupaChups 4.2) i problemi di Lag o drenaggio di

batteria si risolvono in un lampo senza dover diminuire la risoluzione

del Display….cosa inutile perchè cmq tutti i pixel devono essere

illuminati e refreshati :)

Se volete aumentare la batteria è

possibile effettuare un undervolt del processore così da ottimizzare i

consumi del propio terminale.

Ad oggi poi con il rilascio di 2 settimana fa dela versione Lollpop 20H del SW hanno ulteriormente migliorato la rom stock

Ancora non mi è arrivato aggiornamento a Lollipop g3 della tre,qualcuno di voi ha aggiornato con altro firm e quale?

Dovrebbe essere arrivato per i brand 3! Già da molto tempo… Vai su Aggiornamento software e controlla (lo avrai già fatto sicuramente

Fatemi commentare dato che lo possiedo…

Innanzitutto le grafiche 3D non registrano mai meno di 10000 punti su antutu,infatti siamo sui 12000 in Quad Hd. FullHd invece é sopra i 14000(quindi il valore misurato é corretto)

Poi,con il Quad Hd l’unica cosa penalizzata é la grafica 3D,affaticando principalmente la gpu,mentre per il resto le prestazioni sono solo leggermente inferiori.

Anch’io tengo il G3 in FullHd,per avere migliori performance nel gaming.

Vorrei sottokineare però che la scelta di uno schermo QuadHd non é una cosa insensata. Le differenze ci sono,e si vedono,nella maggior nitidezza dei contorni delle figure. Parlo io che da vicino vedo molto,riesco quasi a distinguere i pixel degli schermi fullHd nei contorni delle figure “tonde” (lo so,vi sembrerà strano,ma é così,vedo molto da vicino e poco da lontano XD),mentre col QuadHd é tutto migliore e piú definito.

Abbassando la risoluzione cosi diventa un g2

Consigliate di fare la stessa cosa con s4? Potrei aumentare l’autonomia se lo setto a quanto?

il “test sulla batteria” non ha significato… la risoluzione da renderizzare è minore quindi la cpu consuma leggermente meno, ma i pixel da accendere restano sempre 1440×2560, ergo il diplay consuma uguale… potrebbero anche renderizzare a 640×480 ma il display rimane un QHD e accende tutti i pixel comunque.

Scusate ma a me questo test sembra una cavolata.

Ok ridurre la risoluzione va a vantaggio delle prestazioni grafiche (il SoC a parità di potenza di elaborazione deve elaborare meno immagini).

Però il monitor ha sempre la sua risoluzione, ci sarà uno scaler che converte la risoluzione da Full HD a QHD…come avviene per il digitale terrestre sulle nostre TV!

Sarebbe stato interessante se fosse possibile trapiantare un monitor full-hd come quello del G2 sul G3 e notare la differenza!

Altrimenti è un test inutile! Lo sanno anche le capre che su un PC normale un giochino che ti va a scatti, va più fluido se riduci la risoluzione!

Seghe mentali (e fisiche) su uno schermo, ed io che spreco tempo su Brazzers.